در روزهای اخیر هر روز در مورد افزایش قیمت سهام شرکت انویدیا و تبدیل شدن به پر ارزشترین شرکت جهان میشنویم. این شرکت که غول سخت افزارهای هوش مصنوعی است حالا همه توجهات را به سمت خود جلت کرده است.

هیچ یک از ابزارهای هوش مصنوعی که امروزه از آنها استفاده میکنیم بدون وجود سختافزارهای هوش مصنوعی به وجود نمیآمدند. با پیچیده تر شدن برنامه های هوش مصنوعی (AI)، تقاضا برای سخت افزارهای تخصصی که قادر به پردازش کارآمد باشند افزایش یافته است. واحدهای پردازش گرافیکی (GPU)، واحدهای پردازش تانسور (TPU) و واحدهای پردازش عصبی (NPU) هر کدام نقشهای متمایزی را در میان انواع سختافزار هوش مصنوعی ایفا میکنند و قابلیتها و بهینهسازیهای مختلفی را ارائه میکنند که متناسب با جنبههای مختلف پردازش هوش مصنوعی است.

این مقدمه به بررسی تفاوتهای اساسی و کاربردهای خاص این فناوریها میپردازد و چگونگی پاسخگویی به نیازهای متنوع چالشهای هوش مصنوعی دنیای مدرن را روشن میکند.

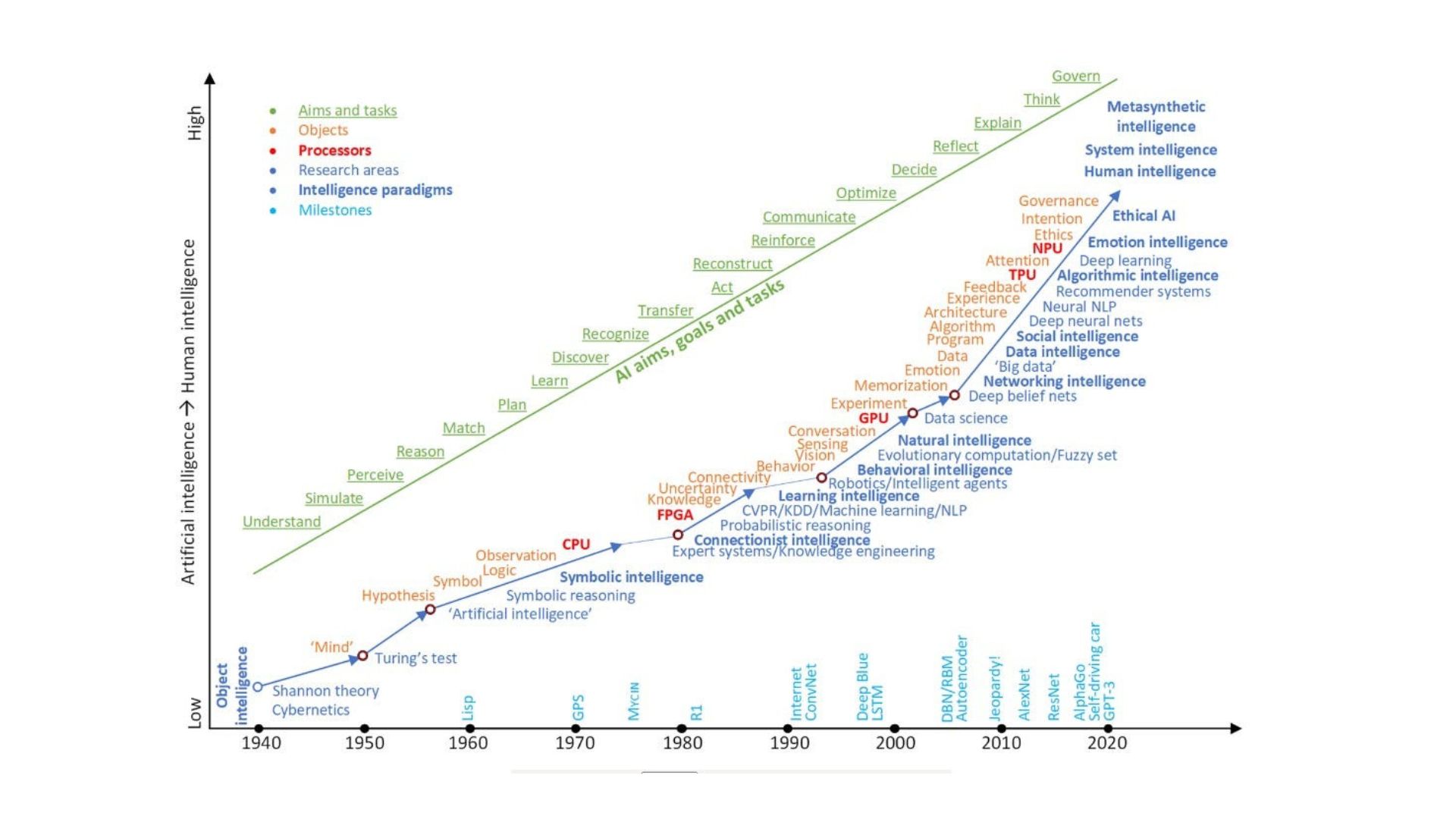

تکامل سخت افزارهای مخصوص هوش مصنوعی

تکامل سختافزارهای تخصصی هوش مصنوعی، بهویژه پردازندههای گرافیکی، TPU و NPU، با نقاط عطف قابل توجهی مشخص شده است که نشاندهنده پیشرفتهای سریع در فناوری با هدف پاسخگویی به نیازهای روز افزون هوش مصنوعی و برنامههای کاربردی یادگیری ماشین است. در اینجا سیر تاریخی این تکامل را بررسی میکنیم.

معرفی GPU: در سال ۱۹۹۹ شرکت انویدیا GeForce 256 را معرفی کرد، اولین GPU که در ابتدا برای رندر گرافیکی طراحی شده بود اما بعداً به دلیل قابلیت های پردازش موازی آن برای محاسبات هوش مصنوعی به کار گرفته شد. این شروع استفاده از واحدهای گرافیکی برای کارهای پیچیده محاسباتی فراتر از بازی بود.

راه اندازی CUDA: در سال ۲۰۰۷ انویدیا CUDA ، یک پلتفرم محاسباتی موازی و مدل رابط برنامه نویسی برنامه (API) را راه اندازی کرد. این به توسعهدهندگان اجازه داد تا از زبان برنامه نویسی C برای نوشتن نرم افزاری استفاده کنند که بتواند کار محاسباتی را روی GPU انجام دهد. این نوآوری به طور قابل توجهی استفاده از پردازندههای گرافیکی را در هوش مصنوعی و محاسبات علمی افزایش داد.

استفاده گسترده Google Brain از پردازندههای گرافیکی: در سال ۲۰۱۳، Google Brain از پردازندههای گرافیکی استفاده کرد تا زمان مورد نیاز برای آموزش شبکههای عصبی بزرگ را به میزان قابل توجهی کاهش دهد و پتانسیل پردازندههای گرافیکی را در تسریع وظایف هوش مصنوعی نشان داد، که لحظهای مهم برای سختافزار هوش مصنوعی بود.

معرفی TPU ها: در سال ۲۰۱۶ گوگل واحد پردازش تانسور (TPU) را معرفی کرد. TPU یک مدار مجتمع مخصوص برنامه (ASIC) است که به طور خاص برای تسریع وظایف یادگیری ماشین ساخته شده است.

اولین NPU در دستگاه ها: در سال ۲۰۱۷ شرکت هواوی Kirin 970 را معرفی کرد، اولین چیپست در یک گوشی هوشمند که دارای واحد پردازش عصبی (NPU) اختصاصی است. این نوآوری با هدف افزایش قابلیتهای هوش مصنوعی مانند تشخیص تصویر به طور مستقیم بر روی دستگاه، به نمایش گذاشتن پتانسیلهای NPU در لوازم الکترونیکی مصرفی انجام شد.

اعلامیه Edge TPU: در سال ۲۰۱۸ گوگل Edge TPU را معرفی کرد، یک نسخه کوچکتر و کم مصرف تر از TPU خود که برای انجام استنتاج یادگیری ماشین در لبه طراحی شده است. این توسعه اهمیت رو به رشد رایانش لبه در برنامه های کاربردی هوش مصنوعی را برجسته کرد.

پردازندههای گرافیکی بهینهشده با هوش مصنوعی: در سال ۲۰۲۰ انویدیا پردازنده گرافیکی A100 را بر اساس معماری Ampere منتشر کرد که شتاب بیسابقهای را برای بارهای کاری هوش مصنوعی فراهم میکرد و در رسیدگی به نیازهای برنامههای هوش مصنوعی مدرن، از جمله آموزش کارآمدتر مدلهای بزرگتر، حیاتی بود.

گسترش کاربردهای NPU: درسال ۲۰۲۱ معرفی تراشه M1 توسط اپل، که شامل یک NPU قدرتمند است، بر اهمیت ادغام قابلیتهای پردازش عصبی به طور مستقیم در دستگاههای محاسباتی اصلی، بهبود وظایفی مانند تجزیه و تحلیل ویدئو و تشخیص صدا تاکید کرد.

تراشههای هوش مصنوعی کوانتومی شروع به آزمایش کردند: در سال ۲۰۲۳ شرکتهایی مانند IBM آزمایش تراشههای هوش مصنوعی کوانتومی را آغاز کردند، که نشاندهنده یک جهت بالقوه آینده برای سختافزار هوش مصنوعی است که قادر به پردازش محاسبات پیچیده با سرعتهای غیرقابل دستیابی توسط پردازندههای کلاسیک است.

این نقاط عطف نه تنها تکامل سریع و تخصصی شدن سختافزار هوش مصنوعی را نشان میدهد، بلکه تلاشهای مداوم صنعت برای برآورده کردن نیازهای محاسباتی برنامههای کاربردی پیشرفته هوش مصنوعی و ML را نیز برجسته میکند. هر توسعه به پیشرفت های قابل توجهی در سرعت پردازش، بهره وری انرژی و توانایی انجام وظایف پیچیده هوش مصنوعی کمک کرده است و قابلیت های فناوری های هوش مصنوعی را در بخش های مختلف به پیش می برد.

تفاوت بین GPU و TPU و NPU چیست؟

درک تفاوت های کلیدی بین GPU، TPU و NPU برای انتخاب سخت افزار مناسب برای وظایف خاص هوش مصنوعی بسیار مهم است. هر نوع پردازنده دارای ویژگی های منحصر به فردی است که آن را برای کاربردهای خاصی در زمینه هوش مصنوعی مناسب می کند. در این بخش به بررسی این مفاهیم و تفاوتهای آنها با هم میپردازیم.

واحدهای پردازش گرافیکی (GPU)

GPU ها در اصل برای ارائه گرافیک در بازیهای ویدیویی طراحی شده بودند، GPU ها به پردازندههای موازی بسیار کارآمد تبدیل شدهاند. آنها مجهز به هزاران هسته هستند که می توانند چندین عملیات را به طور همزمان انجام دهند و آنها را برای محاسبات ماتریسی و برداری مورد نیاز در یادگیری عمیق و سایر وظایف پردازش داده گسترده ایدهآل می کند. پردازندههای گرافیکی همه فن حریف هستند و میتوانند برای طیف وسیعی از برنامههای کاربردی فراتر از هوش مصنوعی، مانند مدلسازی سه بعدی و استخراج ارزهای دیجیتال استفاده شوند. با این حال، به دلیل تمرکز طراحی گستردهتر، معمولاً نسبت به TPU و NPU کارایی کمتری نسبت به وظایف تخصصی هوش مصنوعی دارند.

واحدهای پردازش تانسور (TPU)

TPU ها توسط Google به وجود آمدند، TPUها مدارهای مجتمع ویژه برنامه (ASIC) هستند که به طور خاص برای یادگیری ماشین شبکه عصبی طراحی شدهاند. معماری یک TPU برای حجم بالایی از محاسبات با دقت کم، بهینه شده است، که در محیطهای یادگیری عمیق متداول است، که آنها را برای این منظور بسیار سریع و کم مصرف می کند. TPU ها به ویژه برای استنباط آموزشی و اجرای مدلهای یادگیری ماشینی در مقیاس بزرگ مناسب هستند، اما نسبت به GPUها انعطاف پذیری کمتری دارند زیرا تنها برای انجام مجموعهای از وظایف طراحی شدهاند.

واحدهای پردازش عصبی (NPU)

NPUها نوع دیگری از ASIC هستند که برای تسریع محاسبات شبکه عصبی طراحی شدهاند. آنها شبیه TPUها هستند زیرا برای کارهای یادگیری ماشینی بهینه شدهاند، اما عموماً به جای آموزش بیشتر در جهت استنتاج به کار گرفته میشوند. NPUها معمولاً در دستگاههای تلفن همراه و دستگاه های محاسباتی لبه یافت میشوند که در آنها بهرهوری انرژی و توانایی اجرای برنامه های هوش مصنوعی به طور مستقیم بر روی دستگاه (بدون اتصال ابری) بسیار مهم است. اگرچه آنها راندمان بالایی ارائه میدهند، اما دامنه کاربرد آنها در مقایسه با GPU و TPU محدودتر است.

هر نوع پردازنده نقاط قوت خود را دارد و به بهترین وجه برای انواع خاصی از وظایف در جریان کاری هوش مصنوعی مناسب است. پردازندههای گرافیکی انعطافپذیری و قدرت خام بسیار خوبی را ارائه میدهند و آنها را برای طیف گستردهای از برنامهها، از جمله موارد خارج از هوش مصنوعی، مناسب میسازد. با این حال، TPUها برای کارهایی که میتوانند با معماری خاص آنها، بهویژه مدلهای یادگیری ماشینی در مقیاس بزرگ، تنظیم شوند، عملکرد و کارایی بالاتری ارائه میدهند. NPU ها برای برنامه های محاسباتی لبه ای ایده آل هستند که در آن بهره وری انرژی و توانایی انجام پردازش بلادرنگ بر روی دستگاه بسیار مهم است. درک این تفاوت ها به تصمیم گیری آگاهانه در مورد اینکه کدام سخت افزار را برای برنامه های کاربردی خاص هوش مصنوعی مستقر کنیم کمک می کند.

پردازندههای گرافیکی هوش مصنوعی پیشرو در معیارهای 2024

در سال 2024، معیارهای عملکرد پردازندههای گرافیکی در برنامههای هوش مصنوعی شاهد پیشرفتهای قابل توجهی بودهاند که انویدیا و اینتل در این زمینه پیشرو هستند. در اینجا یک تجزیه و تحلیل دقیق از GPUهای برتر بر اساس آخرین معیارهای MLPerf 4.0 و پیامدهای آنها برای شرکت های هوش مصنوعی آورده شده است

پردازنده گرافیکی Nvidia H200

با تکیه بر موفقیت نسل قبلی خود، H100، پردازنده گرافیکی Nvidia H200 در آزمایش با مدل Llama 2، سرعت استنتاج 45 درصدی را افزایش داده است. این بهبود برای شرکتهای هوش مصنوعی که بر روی وظایفی مانند پردازش زبان طبیعی و عملیات استنتاج در مقیاس بزرگ تمرکز میکنند، که سرعت و دقت در اولویت هستند، بسیار مهم است. عملکرد پیشرفته H200 نتیجه اصلاح مداوم معماری گریس هاپر توسط انویدیا است و آن را به انتخابی برتر برای مراکز داده و مراکز تحقیقاتی هوش مصنوعی تبدیل می کند که به دنبال مدیریت کارآمد مدل های پیچیده تر و مجموعه داده های بزرگتر هستند.

شتابدهنده هوش مصنوعی Intel Gaudi 2

اینتل با شتاب دهنده هوش مصنوعی Gaudi 2 پیشرفت های قابل توجهی در بازار GPU داشته است. اگرچه Gaudi 2 اینتل در عملکرد خام هنوز از پیشنهادات انویدیا عقب مانده است، اما Gaudi 2 اینتل معیارهای قیمت-عملکرد بهتری را ارائه می دهد، که پیشنهادی جذاب برای شرکت های هوش مصنوعی است که به دنبال بهینه سازی هزینه عملیات خود هستند. این پردازنده گرافیکی مخصوصاً برای برنامههایی که نیاز به تعادل بین هزینه و عملکرد دارند مفید است و آن را به گزینهای مناسب برای استارتآپها و سرمایهگذاریهای کوچکتر هوش مصنوعی تبدیل میکند که نیاز به مدیریت دقیق سرمایهگذاریهای سختافزاری خود دارند.

Nvidia RTX 4090

جدا از استفاده در بازی و تولید محتوا، Nvidia RTX 4090 عملکرد استثنایی در کارهای مرتبط با هوش مصنوعی، به ویژه در آموزش مدل های هوش مصنوعی و استنتاج با استفاده از چارچوب هایی مانند Stable Diffusion نشان داده است. توانایی آن در مدیریت کارآمد بارهای کاری هوش مصنوعی، که تقریباً سه برابر سریعتر از رقبای خود در برخی وظایف هوش مصنوعی است، آن را به یک دارایی ارزشمند برای شرکتهای هوش مصنوعی درگیر در تولید تصویر و سایر برنامههای کاربردی فشرده هوش مصنوعی تبدیل میکند. عملکرد برتر RTX 4090 هم در معیارهای سنتی و هم در معیارهای مخصوص هوش مصنوعی تضمین میکند که برای کارهای محاسباتی هوش مصنوعی با کارایی بالا، انتخابی ارجح باقی میماند.

پردازنده Xeon نسل پنجم اینتل

پردازنده Xeon نسل پنجم اینتل به دلیل بهبود عملکرد چشمگیر در وظایف هوش مصنوعی باید در این لیست باشد. با افزایش سرعت 1.9 برابری در معیار خلاصهسازی متن GPT-J LLM نسبت به نسل قبلی خود، این CPU جایگزین مناسبی برای شرکتهای هوش مصنوعی است که برای استنتاج و آموزش مدل در مقیاس کوچکتر به معماریهای مبتنی بر CPU متکی هستند. این به ویژه برای سناریوهایی که در آن استقرار GPU های پیشرفته ممکن است به دلیل محدودیت های بودجه یا الزامات خاص برنامه امکان پذیر نباشد، مرتبط است.

این پردازندههای گرافیکی و پردازندههای گرافیکی چشمانداز سختافزار هوش مصنوعی را شکل میدهند و طیف وسیعی از گزینههای متناسب با نیازهای محاسباتی و ملاحظات بودجه را در اختیار شرکتهای هوش مصنوعی قرار میدهند. بهبود مستمر در فناوری GPU، همانطور که توسط معیارهای MLPerf 4.0 مشهود است، بر ماهیت پویای بازار سختافزار هوش مصنوعی و نقش حیاتی آن در پیشرفت تحقیقات و برنامههای کاربردی هوش مصنوعی تأکید میکند.

نسل بعدی سختافزارهای هوش مصنوعی: چیزی فراتر از GPU و TPU و NPU

همانطور که چشم انداز سخت افزار هوش مصنوعی در حال تکامل است، انتظار می رود نسل بعدی پردازنده ها بر تخصص و ادغام بیشتر تمرکز کنند تا وظایف پیچیده هوش مصنوعی را انجام دهند. این پیشرفت به دنبال رفع محدودیتهای فناوریهای فعلی مانند GPU، TPU و NPU با افزایش سازگاری، کارایی و توانایی پردازش الگوریتمهای هوش مصنوعی در لبه شبکهها است. در ادامه برخی از این موارد معرفی خواهد شد.

ASIC های تخصصی

مدارهای مجتمع ویژه برنامه های کاربردی پیشرفته (ASIC) با تمرکز عمیقتر بر عملکردهای خاص هوش مصنوعی طراحی میشوند. این تراشهها برای بهینهسازی جنبههای خاصی از پردازش هوش مصنوعی، مانند سرعت انتقال داده سریعتر و کاهش تأخیر برای برنامههای هوش مصنوعی در زمان واقعی، طراحی شدهاند. برخلاف پردازندههای همه منظوره، این ASICهای تخصصی میتوانند بهبود عملکرد قابل توجهی را برای وظایف هدفمند در جریانهای کاری هوش مصنوعی ارائه دهند.

FPGA های بهینه شده با هوش مصنوعی

آرایههای دروازهای قابل برنامهریزی میدانی (FPGA) به دلیل انعطافپذیری و کاراییشان قرار است در راهحلهای سختافزاری هوش مصنوعی رایجتر شوند. FPGA ها را می توان برای سازگاری با الگوریتم ها و برنامه های مختلف مجددا برنامه ریزی کرد و آنها را برای سیستم های هوش مصنوعی تطبیقی که در طول زمان تکامل می یابند ایده آل می کند. پیشرفتهای آینده در فناوری FPGA احتمالاً سهولت استفاده و ادغام آنها را با چارچوبهای توسعه هوش مصنوعی موجود افزایش میدهد و آنها را برای محققان و توسعهدهندگان هوش مصنوعی در دسترستر میسازد.

تراشه های هوش مصنوعی کوانتومی

محاسبات کوانتومی یک رویکرد انقلابی برای پردازش اطلاعات ارائه میکند و تراشههای هوش مصنوعی کوانتومی به عنوان گام بعدی بالقوه در سختافزار هوش مصنوعی شروع به ظهور کردهاند. این تراشه ها از اصول مکانیک کوانتومی برای انجام محاسبات پیچیده با سرعتهای بی سابقه استفاده می کنند. در حالی که هنوز در مراحل اولیه توسعه قرار دارد، تراشههای هوش مصنوعی کوانتومی میتوانند قابلیتهای هوش مصنوعی را بهویژه در زمینههایی مانند مشکلات بهینهسازی و شبیهسازی مواد، به شدت تسریع کنند.

پردازنده های هوش مصنوعی Edge

فشار به سمت محاسبات لبهای نیازمند پردازندههای هوش مصنوعی است که بتوانند در محیطهای با محدودیت انرژی کارآمد عمل کنند. نسل بعدی سختافزار هوش مصنوعی احتمالاً شامل پردازندههای هوش مصنوعی پیشرفتهتر میشود که میتوانند وظایف پیچیده هوش مصنوعی را مستقیماً روی دستگاههایی مانند گوشیهای هوشمند، دستگاههای IoT و وسایل نقلیه خودران انجام دهند. این پردازندهها برای مصرف انرژی کم بهینهسازی شدهاند و در عین حال توان محاسباتی لازم را برای انجام کارهایی مانند تشخیص تصویر و تصمیمگیری بلادرنگ فراهم میکنند.

تراشه های نورومورفیک

تراشه های نورومورفیک با الهام از مغز انسان، ساختار و عملکرد نورون ها و سیناپس ها را تقلید می کنند و به طور بالقوه منجر به سیستم های هوش مصنوعی کارآمدتر و سازگارتر می شوند. این تراشهها اطلاعات را به روشهایی پردازش میکنند که اساساً با پردازندههای سنتی متفاوت است و به طور بالقوه بهبودهایی را در کارایی یادگیری و مصرف انرژی ارائه میدهند. فناوری نورومورفیک برای کاربردهایی که نیاز به انطباق مستقل با اطلاعات جدید، مانند روباتیک و شبکه های حسگر پیچیده دارند، نویدبخش است.

هر یک از این پیشرفت ها نشان دهنده یک گام مهم فراتر از قابلیت های GPU ها، TPU ها و NPU های فعلی است که هدف آن رسیدگی به تقاضاهای رو به رشد برنامه های کاربردی هوش مصنوعی در بخش های مختلف است. با توسعه این فناوریها، انتظار میرود که نقشهای مهمی در آینده سختافزار هوش مصنوعی ایفا کنند و نوآوریهایی را که میتوانند صنایع و زندگی روزمره را متحول کنند، هدایت کنند.

تراشههای هوش مصنوعی مغزی: نوآوریها و تحولات در سختافزار هوش مصنوعی

Cerebras Systems اخیراً جدیدترین پردازنده هوش مصنوعی خود را با نام Wafer-Scale Engine 3 (WSE-3) معرفی کرده است که پیشرفت قابل توجهی در فناوری سخت افزار هوش مصنوعی را نشان می دهد. این تراشه جدید برای افزایش چشمگیر کارایی و عملکرد آموزش و استنتاج مدل هوش مصنوعی طراحی شده است و معیارهای جدیدی را در این زمینه تعیین می کند. در اینجا جنبه های کلیدی نحوه تغییر چشم انداز سخت افزار هوش مصنوعی WSE-3 بررسی میشود.

مقیاس و عملکرد بی سابقه WSE-3

WSE-3 حاوی 4 تریلیون ترانزیستور است و قادر به ارائه 125 پتافلاپ قدرت محاسباتی است که افزایش قابل توجهی نسبت به نسل قبلی خود دارد. این باعث میشود که آن را به بزرگترین و قدرتمندترین تراشه هوش مصنوعی در حال حاضر در دسترس تبدیل کند و جایگاه Cerebras را در خط مقدم سختافزار هوش مصنوعی با کارایی بالا حفظ کند.

بهره وری انرژی بالا

WSE-3 علیرغم افزایش قابلیت هایش، از همان مقدار انرژی که نسل قبلی است استفاده می کند، یکی از چالش های مهم در سخت افزار هوش مصنوعی یعنی مصرف انرژی را برطرف می کند. این کارایی بسیار مهم است زیرا هزینه های مربوط به تامین انرژی و خنک کردن سیستم های هوش مصنوعی به نگرانی های مهمی برای مراکز داده و امکانات تحقیقاتی تبدیل شده است.

ادغام با Qualcomm AI 100 Ultra

در یک حرکت استراتژیک برای افزایش قابلیت های استنتاج هوش مصنوعی، Cerebras با Qualcomm شریک شده است. سیستمهای WSE-3 با تراشههای AI 100 Ultra کوالکام، که برای بهینهسازی فاز استنتاج برنامههای هوش مصنوعی طراحی شدهاند، یکپارچه خواهند شد. هدف این مشارکت کاهش دهی هزینه عملیات استنتاج، استفاده از تکنیک هایی مانند فشرده سازی داده های وزنی و پراکندگی برای بهبود کارایی است.

استقرار در سیستمهای هوش مصنوعی پیشرفته

WSE-3 در نسل جدیدی از ابررایانههای هوش مصنوعی، از جمله راهاندازی در مرکز داده دالاس که قادر به دستیابی به 8 اگزافلاپس قدرت پردازشی است، نصب میشود. این استقرار بر نقش تراشه در تسهیل محاسبات هوش مصنوعی در مقیاس بسیار بزرگ تأکید می کند، که برای آموزش و اجرای بزرگترین مدل های هوش مصنوعی، از جمله مدل هایی با حداکثر 24 تریلیون پارامتر ضروری است.

تاثیر بازار و رقابت

معرفی WSE-3 توسط Cerebras در زمانی انجام می شود که تقاضا برای سخت افزار هوش مصنوعی قدرتمندتر و کارآمدتر در حال افزایش است. با دوبرابر کردن عملکرد بدون افزایش مصرف انرژی، Cerebras نه تنها استاندارد جدیدی را برای آنچه از نظر فناوری امکان پذیر است تعیین می کند، بلکه رقابت با دیگر بازیگران اصلی مانند Nvidia و AMD در بازار سخت افزار هوش مصنوعی را تشدید می کند.

WSE-3 توسط Cerebras نشاندهنده یک جهش در سختافزار هوش مصنوعی است که مرزهای ممکن را از نظر مقیاس، کارایی و عملکرد پیش میبرد. این پیشرفت احتمالاً توسعه و استقرار برنامه های کاربردی پیشرفته هوش مصنوعی را تسریع می کند و هوش مصنوعی در مقیاس بزرگ را در دسترس تر و مقرون به صرفه تر می کند.

کمبود جهانی GPU

کمبود مداوم GPU جهانی پیامدهای مهمی در بخشهای مختلف از جمله بازی، توسعه هوش مصنوعی و لوازم الکترونیکی مصرفی عمومی دارد. این کمبود عمدتاً ناشی از ترکیبی از افزایش تقاضا برای برنامه های کاربردی هوش مصنوعی، اختلال در زنجیره تامین و خرید استراتژیک توسط شرکتهایی است که نیازهای آینده را پیش بینی می کنند. در این بخش نگاهی به وضعیت فعلی و راهحل های بالقوه میاندازیم

افزایش تقاضا برای هوش مصنوعی و بازی

افزایش تقاضا برای پردازندههای گرافیکی از سوی شرکتهای هوش مصنوعی و صنعت بازی یکی از عوامل اصلی کمبود است. پردازندههای گرافیکی برای ارائه گرافیک با کیفیت بالا در بازیهای ویدیویی و برای تقویت الگوریتمهای پیچیده هوش مصنوعی بسیار مهم هستند. این تقاضا با افزایش فناوریهای هوش مصنوعی و افزایش محبوبیت بازی در طول همهگیری تشدید شده است.

اختلالات زنجیره تامین

زنجیره تامین جهانی نیمه هادی ها به دلیل همه گیری COVID-19 با اختلالات قابل توجهی روبرو شده است که بر تولید و توزیع GPU ها تأثیر می گذارد. این اختلالات شامل تاخیر در تولید، چالشهای لجستیکی و کمبود نیروی کار است که همگی به کمبود طولانیمدت پردازندههای گرافیکی در بازار کمک کردهاند.

خرید انبوه استراتژیک

شرکتهایی که نیاز به قدرت محاسباتی قابل توجهی برای برنامههای هوش مصنوعی را پیشبینی میکنند، پردازندههای گرافیکی را در مقادیر زیادی خریداری کردهاند که باعث فشار بیشتر به عرضه محدود شده است. این رویه یافتن GPU های موجود با قیمت های مناسب را برای سایر مصرف کنندگان و شرکت های کوچکتر دشوار کرده است.

اسکالپینگ و بازارهای ثانویه

کمبود همچنین منجر به افزایش اسکالپینگ شده است، جایی که افراد یا گروهها پردازندههای گرافیکی را به صورت عمده خریداری میکنند تا با قیمتهای بالاتر دوباره بفروشند. این عمل قیمتها را افزایش داده و خرید پردازندههای گرافیکی با قیمتهای خردهفروشی را برای مصرفکنندگان عادی چالشبرانگیزتر کرده است.

راه حل های بالقوه برای کمبود GPU

افزایش تولید نیمه هادیها

برای رفع علت اصلی کمبود، فشار جهانی برای افزایش ظرفیت تولید نیمه هادی ها وجود دارد. این شامل سرمایه گذاری در کارخانه های ساخت جدید و گسترش امکانات موجود است. دولتها در سرتاسر جهان نیز برای حمایت از تولید نیمهرساناهای محلی برای کاهش وابستگی به تامینکنندگان خارجی وارد عمل میشوند.

تنوع بخشیدن به تامین کنندگان و فناوری ها

شرکت ها در حال بررسی جایگزین هایی برای GPU های سنتی هستند، مانند CPU و انواع دیگر پردازنده های تخصصی مانند FPGA و ASIC. این جایگزین ها می توانند به کاهش برخی از فشارهای تقاضا بر روی GPU ها کمک کنند. علاوه بر این، تنوع بخشیدن به تامین کنندگان و عدم اتکا به تولیدکنندگان بزرگی مانند NVIDIA می تواند به تثبیت زنجیره تامین کمک کند.

تنظیم خریدهای انبوه

اجرای سیاستهایی برای محدود کردن تعداد پردازندههای گرافیکی قابل خریداری در یک زمان ممکن است تأثیر اسکالپینگ و خرید عمده توسط شرکتهای بزرگ را کاهش دهد. چنین مقرراتی می تواند به اطمینان از توزیع عادلانه GPU های موجود در انواع مختلف مصرف کنندگان و صنایع کمک کند.

خدمات پردازنده گرافیکی مبتنی بر ابر

به عنوان یک راه حل کوتاه مدت، مشاغل و افراد می توانند از خدمات پردازنده گرافیکی مبتنی بر ابر، مانند خدمات ارائه شده توسط CUDO Compute استفاده کنند. این پلتفرمها دسترسی به منابع GPU را بدون نیاز به سختافزار فیزیکی فراهم میکنند و راهحلی انعطافپذیر و مقرون به صرفه را در زمان کمبود ارائه میدهند.

کمبود GPU یک موضوع پیچیده است که تحت تأثیر عوامل متعددی قرار دارد، اما با اقدامات استراتژیک و راه حل های نوآورانه می توان تأثیر آن را کاهش داد و به تدریج تعادل را به بازار بازگرداند.

به صورت خلاصه

در چشم انداز به سرعت در حال تحول سخت افزار هوش مصنوعی، تمایز بین GPU، TPU و NPU قابلیت های تخصصی و برنامه های هدفمند هر فناوری را برجسته می کند.

پردازندههای گرافیکی انتخابی همه کاره باقی میمانند و برای طیف وسیعی از وظایف محاسباتی فراتر از هوش مصنوعی، از جمله رندر گرافیکی و شبیهسازیهای علمی، مناسب هستند.

از سوی دیگر، TPUها عملکرد بهینهسازی شدهای را برای چارچوبهای یادگیری ماشینی خاص و آموزش مدلهای در مقیاس بزرگ ارائه میدهند، و آنها را برای شرکتهایی ایدهآل میکنند که به توان عملیاتی و کارایی بالا در عملیات هوش مصنوعی خود نیاز دارند.

NPU ها عمدتاً به محیط های محاسباتی تلفن همراه و لبه پاسخ می دهند، جایی که بهره وری انرژی و توانایی انجام پردازش هوش مصنوعی بر روی دستگاه بسیار مهم است.

همانطور که فناوری هوش مصنوعی به پیشرفت خود ادامه میدهد، انتخاب استراتژیک سختافزار مناسب نقشی محوری در بهرهگیری از پتانسیل کامل برنامههای هوش مصنوعی ایفا میکند و تضمین میکند که هر نوع پردازنده در زمینههایی استفاده میشود که به بهترین وجه با نقاط قوت طراحی و کارایی عملیاتی آن مطابقت دارد.